Japon yapay zeka girişimi Sakana AI, evrimsel bir algoritma kullanarak mevcut modelleri birleştirerek otomatik olarak yeni yapay zeka modelleri üretmeye yönelik bir yöntem geliştirdi. İlk sonuçlar umut verici.

Sakana AI’nin ana fikri, yeni YZ modelleri oluşturmak için evrim ve kolektif zeka gibi doğal ilkeleri kullanmaktır.

Amaç, her seferinde yeni modeller geliştirmek yerine, kullanıcı tanımlı uygulama alanları için otomatik olarak özelleştirilmiş YZ modelleri üreten bir makine geliştirmektir.

Tokyo merkezli startup, “Evrimsel Model Füzyonu” adı verilen evrimden ilham alan yeni bir yönteme dayanan ilk yapay zeka modellerini yayınladı.

Bu, farklı yeteneklere sahip geniş bir açık kaynak model havuzundan farklı modelleri birleştirmenin en iyi yollarını verimli bir şekilde bulmak için evrimsel teknikleri kullanıyor.

Yaklaşım iki yöntem kullanmaktadır: İlk olarak, farklı modellerin katmanları akış uzayında yeniden birleştirilir. İkincisi, parametre uzayında farklı modellerin ağırlıklarını yeniden karıştırır. Evrimsel algoritma, geleneksel yöntemler ve insan sezgisi kullanılarak keşfedilmesi zor olan yeni ve sezgisel olmayan çözümler bulmak için olası kombinasyonların geniş uzayını araştırıyor.

Yöntemi test etmek için Sakana AI otomatik olarak matematiksel yeteneklere sahip bir Japonca Büyük Dil Modeli (LLM) ve bir Japonca Görme Dili Modeli (VLM) geliştirdi.

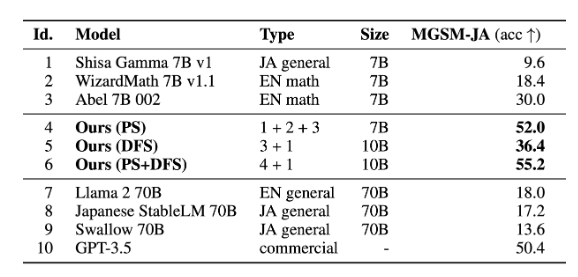

Şaşırtıcı bir şekilde, her iki model de bu ölçütlerde iyi performans gösterecek şekilde açıkça optimize edilmemiş olsalar bile, çeşitli LLM ve görüntü ölçütlerinde son teknoloji ürünü sonuçlar elde etti.

Özellikle, 7 milyar parametreli Japon matematiksel LLM, bir dizi Japon LLM kıyaslamasında önceki 70 milyar parametreli Japon SOTA LLM’lerinden bile daha iyi performans gösterdi. Sakana AI, bu deneysel Japon matematiksel LLM’nin genel amaçlı bir Japon LLM olarak kullanılabilecek kadar iyi olduğuna inanıyor.

Japonca LLM, kültüre özgü içeriği ele almada da oldukça iyidir ve Japonca görüntü-metin çiftleri veri kümesinde mükemmel sonuçlar elde ediyor.

Yöntem, görüntü üretimi için difüzyon modellerine de uygulanabilir. Sakana AI, yalnızca dört difüzyon adımı kullanan yüksek kaliteli, ışık hızında bir Japon SDXL modelinin geliştirilmesinden elde edilen ön sonuçları duyurdu.

Sakana AI, Hugging Face ve GithHub‘da üç Japon vakıf modeli yayınladı.

- Büyük dil modeli (EvoLLM-JP)

- Görme dili modeli (EvoVLM-JP)

- Görüntü oluşturma modeli (EvoSDXL-JP, yakında)

Sakana AI, nöroevrim, kolektif zeka ve temel modellerin birleşimini umut verici uzun vadeli bir araştırma yaklaşımı olarak görüyor. Startup’a göre bu yaklaşım, büyük kuruluşların tamamen tescilli modellere büyük kaynaklar yatırmadan önce artan sayıda açık kaynaklı yapay zeka modelinden yararlanarak özel yapay zeka modellerini daha hızlı ve daha uygun maliyetli bir şekilde geliştirmelerini sağlayabilir.

Yapay zeka ünlüleri tarafından kurulan Sakana AI

Sakana AI, eski Google AI uzmanları Llion Jones ve David Ha tarafından doğadan esinlenen üretken AI modelleri geliştirmek için kurulan Tokyo merkezli bir girişimdir. Bu modeller metin, görüntü, kod ve multimedya gibi çeşitli içerik biçimlerini üretmek üzere tasarlandı.

Kurucular, kolektif zekaya sahip doğal sistemlere benzer şekilde, çevrelerindeki değişikliklere duyarlı ve uyarlanabilir YZ sistemleri oluşturmayı amaçlıyor. Bu, genellikle değişmez yapılar olarak tasarlanan geleneksel YZ modellerinden bir ayrılışı temsil ediyor.

Kurucu ortak Jones, günümüzün birçok YZ başarısının ardındaki derin öğrenme için “transformatör” mimarisini tanıtan ünlü 2017 araştırma makalesi “Attention Is All You Need “in yazarıdır. Lux Capital ve Khosla Ventures gibi yatırımcılardan 30 milyon dolar tohum fonu toplayan girişim, Tokyo’yu San Francisco’daki OpenAI ve Londra’daki Deepmind benzeri bir yapay zeka merkezine dönüştürmeyi hedefliyor.

Yapayzeka.news’in hiçbir güncellemesini kaçırmamak için bizi Facebook, X (Twitter), Bluesky, LinkedIn, Instagram‘ ve Whatsapp Kanalımız‘dan takip edin.