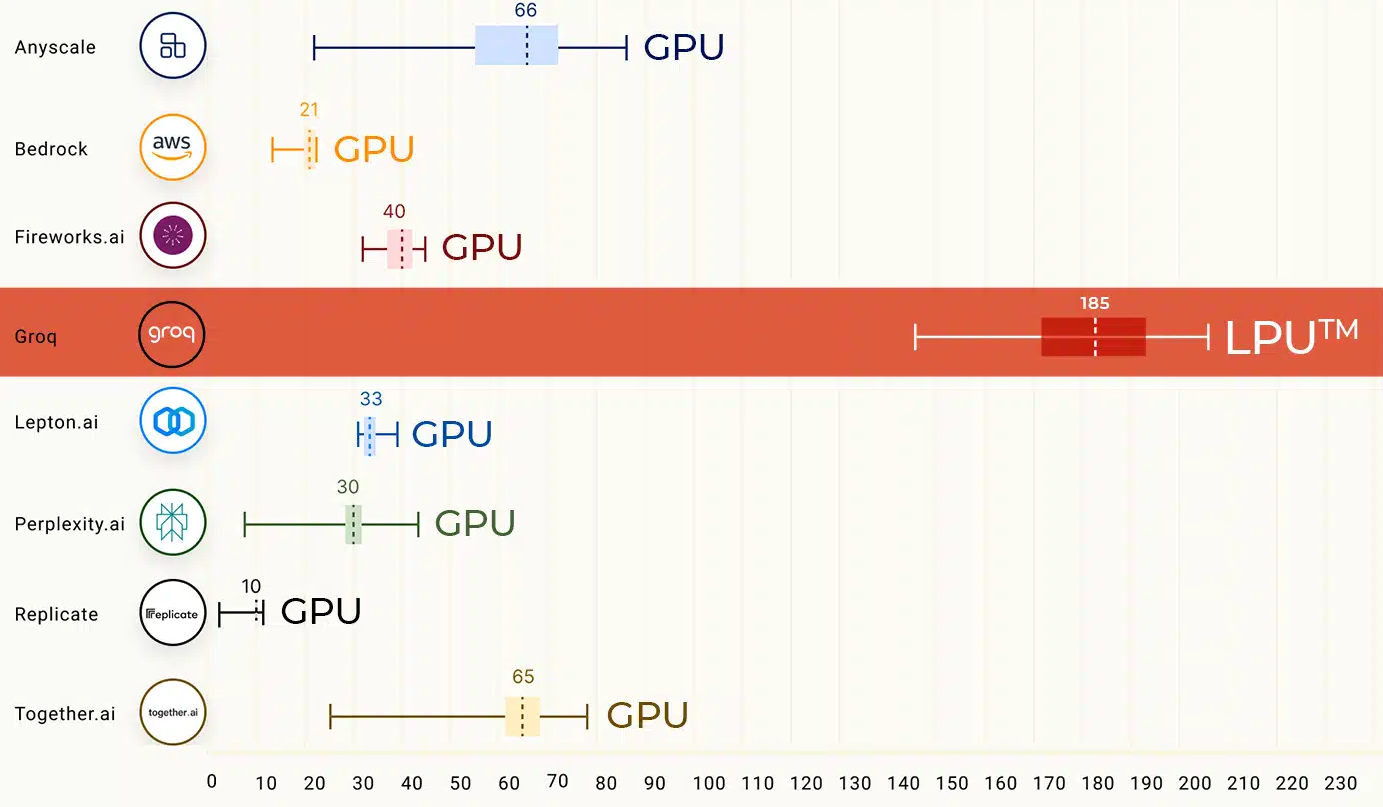

İnsanlarla karşılaştırıldığında, dil modelleri inanılmaz derecede hızlı metin üretebilir. Ancak Groq gibi bazı girişimler için bu yeterince hızlı değil. Bu nedenle daha da hızlı performans elde etmek için Groq özel bir donanım geliştirdi: LPU’lar (Dil İşleme Birimleri).

Bu LPU’lar dil modellerini çalıştırmak için özel olarak tasarlanmıştır ve saniyede 500 jetona kadar hız sunuyor. Buna karşılık, nispeten hızlı LLM’ler Gemini Pro ve GPT-3.5, yük, istem, bağlam ve teslimata bağlı olarak saniyede 30 ila 50 belirteç yönetiyor.

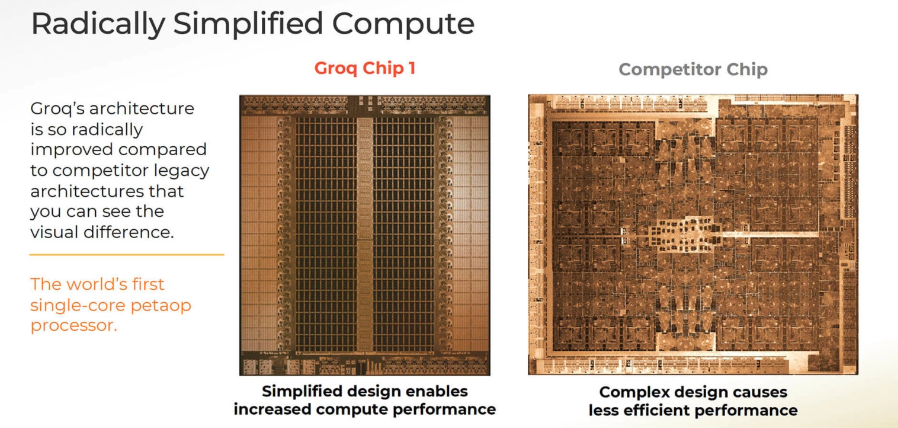

LPU sistem kategorisindeki ilk “GroqChip”, Groq’un performans, verimlilik, hız ve doğruluk için tasarlandığını söylediği bir “tensör akış mimarisi” kullanıyor.

Startup’a göre, geleneksel grafik işleme birimlerinin (GPU’lar) aksine, çip sabit gecikme ve verim sağlayan basitleştirilmiş bir mimari sunuyor. Bu, oyun gibi gerçek zamanlı yapay zeka uygulamaları için bir avantaj olabilir.

Groq, LPU’ların enerji açısından da daha verimli olduğunu söylüyor. Birden fazla iş parçacığını yönetmek için gereken çabayı azaltıyor ve çekirdeklerin yetersiz kullanımını önleyerek watt başına daha fazla hesaplama yapılmasını sağlıyorlar.

Groq’un çip tasarımı, GPU kümeleriyle ilişkili geleneksel darboğazlar olmadan birden fazla TSP’nin bağlanmasına izin veriyor. Groq’a göre bu, sistemi ölçeklenebilir hale getiriyor ve büyük yapay zeka modelleri için donanım gereksinimlerini basitleştiriyor.

Groq’un sistemleri, mevcut yapay zeka projelerine entegrasyonu kolaylaştıracak yaygın makine öğrenimi çerçevelerini desteklemektedir. Groq donanım satıyor ve ayrıca Mixtral gibi açık kaynaklı modellerle bir bulut API’si sunuyor. Groq’un hızını Mixtral ve Llama ile buradan test edebilirsiniz.

Ancak şimdilik LPU’lar yalnızca yapay zeka modellerini çalıştırmak için süslü bir kelime olan çıkarım için çalışıyor. Modelleri eğitmek için şirketlerin hala Nvidia GPU’lara veya benzer çiplere ihtiyacı var. Groq 2016 yılında, daha önce Google’da TPU çipleri üzerinde çalışmış olan Jonathan Ross tarafından kuruldu.

Yapayzeka.news’in hiçbir güncellemesini kaçırmamak için bizi Facebook, Twitter, LinkedIn, Instagram‘ ve Whatsapp Kanalımız‘dan takip edin.