Dünya en son yapay zeka teknolojileri dalgasından yararlanmak için acele ederken, yüksek teknoloji ürünü bir donanım şaşırtıcı derecede sıcak bir meta haline geldi: Grafik işlem birimi veya GPU.

En üst düzey bir GPU on binlerce dolara satılabiliyor ve lider üretici NVIDIA, ürünlerine olan talep arttıkça piyasa değerinin 2 trilyon ABD Dolarını aştığını gördü.

GPU’lar sadece üst düzey yapay zeka ürünleri de değil. Telefonlarda, dizüstü bilgisayarlarda ve oyun konsollarında da daha az güçlü GPU’lar var.

Şimdiye kadar muhtemelen merak ediyorsunuzdur: GPU gerçekten nedir? Ve onları bu kadar özel yapan nedir?

GPU nedir?

GPU’lar başlangıçta video oyunları ve bilgisayar destekli tasarım yazılımlarında olduğu gibi karmaşık 3D sahneleri ve nesneleri hızlı bir şekilde oluşturmak ve görüntülemek için tasarlandı. Modern GPU’lar ayrıca video akışlarının sıkıştırmasını açma gibi görevleri de yerine getiriyor.

Çoğu bilgisayarın “beyni” merkezi işlem birimi (CPU) adı verilen bir çiptir. CPU’lar grafiksel sahneler oluşturmak ve videoları açmak için kullanılabilir, ancak GPU’lara kıyasla bu görevlerde genellikle çok daha yavaş ve daha az verimlidirler. CPU’lar kelime işleme ve web sayfalarında gezinme gibi genel hesaplama görevleri için daha uygun.

GPU’ların CPU’lardan farkı nedir?

Tipik bir modern CPU, her biri karmaşık görevleri sıralı bir şekilde işleyebilen 8 ila 16 “çekirdekten” oluşur.

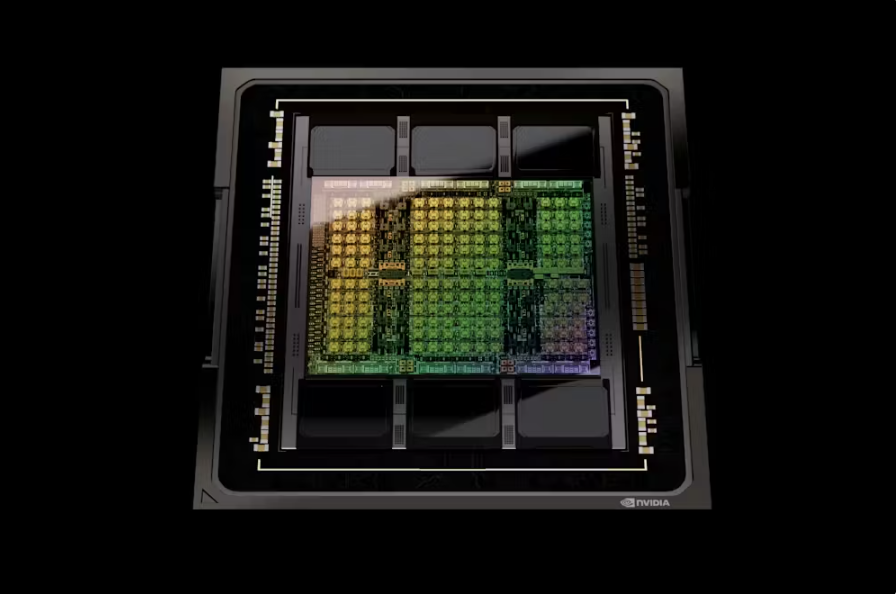

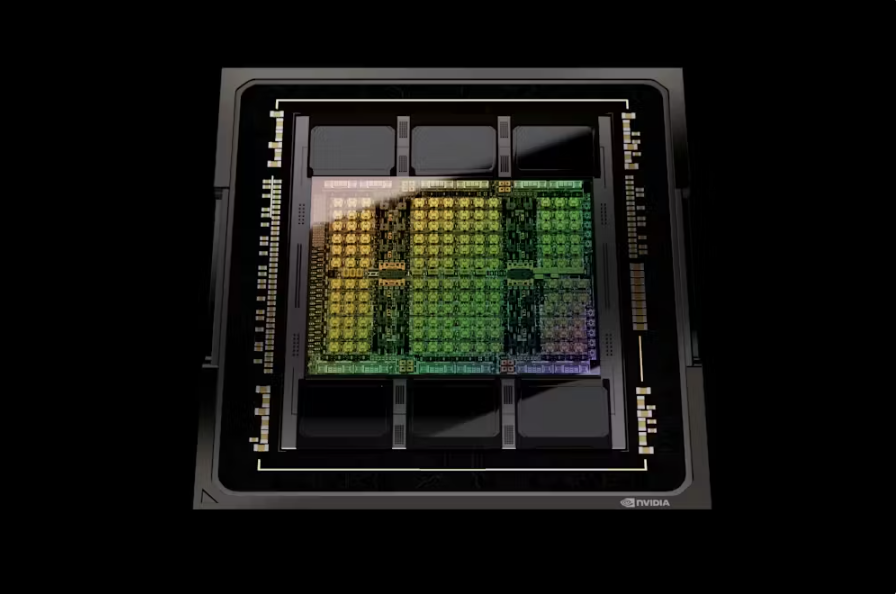

Öte yandan GPU’lar, hızlı genel işleme elde etmek için hepsi aynı anda (“paralel”) çalışmak üzere tasarlanmış binlerce nispeten küçük çekirdeğe sahip. Bu da onları, birbiri ardına değil de aynı anda yapılabilecek çok sayıda basit işlem gerektiren görevler için çok uygun hale getirir.

Geleneksel GPU’ların iki ana çeşidi vardır.

İlk olarak, genellikle büyük masaüstü bilgisayarlar için eklenti kartlarda bulunan bağımsız çipler var. İkincisi, genellikle dizüstü bilgisayarlarda ve PlayStation 5 gibi oyun konsollarında bulunan, aynı çip paketinde bir CPU ile birleştirilmiş GPU’lardır. Her iki durumda da CPU, GPU’nun ne yaptığını kontrol eder.

GPU’lar yapay zeka için neden bu kadar kullanışlı?

GPU’ların grafiksel sahneler oluşturmaktan daha fazlasını yapmak için yeniden kullanılabileceği ortaya çıktı.

Derin sinir ağları gibi yapay zekanın (AI) arkasındaki makine öğrenimi tekniklerinin çoğu, büyük ölçüde “matris çarpımının” çeşitli biçimlerine dayanır.

Bu, çok büyük sayı kümelerinin çarpıldığı ve toplandığı matematiksel bir işlem. Bu işlemler paralel işlemeye çok uygun ve dolayısıyla GPU’lar tarafından çok hızlı bir şekilde gerçekleştirilebilir.

GPU’lar için sırada ne var?

GPU’ların sayı kırma becerisi, çekirdek sayısındaki ve çalışma hızlarındaki artışa bağlı olarak giderek artmaktadır. Bu gelişmeler öncelikle Tayvan’daki TSMC gibi şirketlerin çip üretimindeki iyileştirmelerinden kaynaklanıyor.

Her bir bilgisayar çipinin temel bileşenleri olan transistörlerin boyutu küçülmekte ve böylece aynı miktarda fiziksel alana daha fazla transistör yerleştirilebilmektedir.

Ancak, hikayenin tamamı bu değil. Geleneksel GPU’lar yapay zeka ile ilgili hesaplama görevleri için kullanışlı olsa da optimum değil.

Tıpkı GPU’ların başlangıçta grafikler için özel işlem sağlayarak bilgisayarları hızlandırmak üzere tasarlanmış olması gibi, makine öğrenimi görevlerini hızlandırmak için tasarlanmış hızlandırıcılar da var. Bu hızlandırıcılar genellikle “veri merkezi GPU’ları” olarak adlandırılır.

AMD ve NVIDIA gibi şirketler tarafından üretilen en popüler hızlandırıcılardan bazıları geleneksel GPU’lar olarak başladı. Zaman içinde tasarımları, örneğin daha verimli “brain float” sayı formatını destekleyerek çeşitli makine öğrenimi görevlerini daha iyi yerine getirecek şekilde gelişti.

Google’ın Tensör İşleme Birimleri ve Tenstorrent’in Tensix Çekirdekleri gibi diğer hızlandırıcılar, derin sinir ağlarını hızlandırmak için sıfırdan tasarlandı.

Veri merkezi GPU’ları ve diğer yapay zeka hızlandırıcıları genellikle geleneksel GPU eklenti kartlarından çok daha fazla belleğe sahiptir ve bu da büyük yapay zeka modellerinin eğitimi için çok önemlidir. Yapay zeka modeli ne kadar büyük olursa, o kadar yetenekli ve doğru olur.

Eğitimi daha da hızlandırmak ve ChatGPT gibi daha da büyük YZ modellerini işlemek için, birçok veri merkezi GPU’su bir süper bilgisayar oluşturmak üzere bir araya getirilebilir. Bu, mevcut sayı işleme gücünü düzgün bir şekilde kullanmak için daha karmaşık bir yazılım gerektiriyor. Diğer bir yaklaşım ise Cerebras tarafından üretilen “wafer-scale processor” gibi çok büyük tek bir hızlandırıcı oluşturmak.

Özel çipler geleceğin ürünü mü?

CPU’lar da yerinde saymıyor. AMD ve Intel’in son CPU’ları, derin sinir ağlarının ihtiyaç duyduğu sayı ezme işlemini hızlandıran yerleşik düşük seviyeli talimatlara sahip. Bu ek işlevsellik esas olarak “çıkarım” görevlerine, yani başka bir yerde geliştirilmiş olan yapay zeka modellerinin kullanılmasına yardımcı oluyor.

Yapay zeka modellerini ilk etapta eğitmek için hala büyük GPU benzeri hızlandırıcılara ihtiyaç var.

Belirli makine öğrenimi algoritmaları için daha da özelleşmiş hızlandırıcılar yaratmak mümkün. Örneğin son zamanlarda Groq adlı bir şirket, ChatGPT çizgisinde büyük dil modellerini çalıştırmak için özel olarak tasarlanmış bir “dil işleme birimi” (LPU) üretti.

Ancak, bu özel işlemcileri oluşturmak önemli mühendislik kaynakları gerektiriyor. Tarih, herhangi bir makine öğrenimi algoritmasının kullanımının ve popülaritesinin zirve yapma ve ardından azalma eğiliminde olduğunu gösteriyor; bu nedenle pahalı özel donanımlar hızla modası geçmiş hale gelebilir.

Ancak ortalama bir tüketici için bunun bir sorun olması pek olası değil. Kullandığınız ürünlerdeki GPU’lar ve diğer çipler muhtemelen sessizce hızlanmaya devam edecek.

Kaynak: Natalie Sauer / The Conversation

Yapayzeka.news’in hiçbir güncellemesini kaçırmamak için bizi Facebook, X (Twitter), Bluesky, LinkedIn, Instagram‘ ve Whatsapp Kanalımız‘dan takip edin.