Google Deepmind, müzisyenler ve sanatçılar için yaratıcılık sürecini geliştirmek üzere tasarlanmış müzik üretimine yönelik bir yapay zeka modeli olan Lyria’yı tanıttı.

Google Deepmind, YouTube ile işbirliği yaparak müzik için iki yapay zeka denemesi başlattı: YouTube shorts’larda bir deney olan Dream Track ve sanatçılar, söz yazarları ve yapımcılar için bir dizi araç olan Music AI Tools.

Lyria modeli vokallerle daha uzun, daha uyumlu parçalar yaratmayı hedefliyor

Lyria modeli, enstrümantal eşlik ve vokallerle yüksek kaliteli müzik oluşturmak için tasarlandı. Google Deepmind’a göre Lyria, heavy metalden teknoya ve operaya kadar birçok türü destekliyor. Şirket, ritimler, melodiler ve vokallerin karmaşıklığını cümleler, dizeler veya daha uzun pasajlar üzerinde koruyabildiğini söylüyor.

Google Deepmind, Dream Track projesinin bir parçası olarak YouTube ile Lyria’yı test ediyor. Deneyin amacı, sanatçıların müzik yapmaları için yeni yollar keşfetmek. Kullanıcılar modelin arayüzüne bir tema ve stil giriyor, karuselden bir sanatçı seçiyor ve bir YouTube kısası için 30 saniyelik bir film müziği oluşturuyor.

Lyria modeli, seçilen katılımcı sanatçının tarzında şarkı sözleri, arka plan müziği ve yapay zeka tarafından oluşturulan ses üretiyor. Öne çıkan sanatçılar arasında Alec Benjamin, Charlie Puth, Charli XCX, Demi Lovato, John Legend, Sia, T-Pain, Troye Sivan ve Papoose yer alıyor.

Google Deepmind araştırmacıları ayrıca, üretici yapay zekanın yaratıcı sürece nasıl yardımcı olabileceğini keşfetmek için YouTube Music AI Incubator’daki sanatçılar, söz yazarları ve yapımcılarla birlikte çalışıyor.

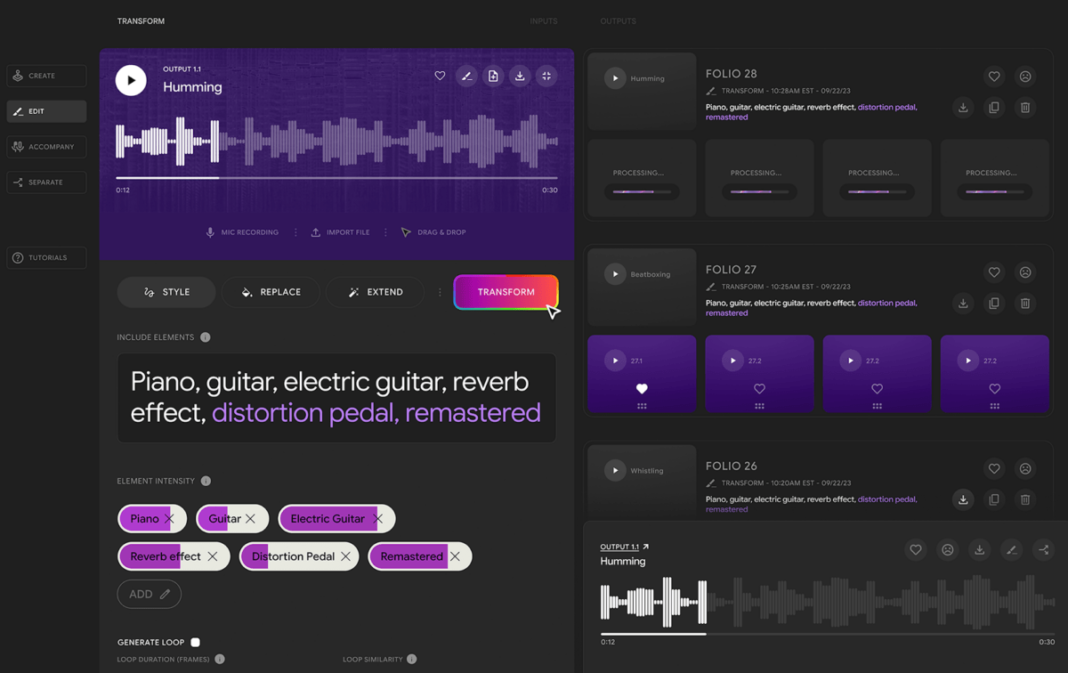

Birlikte, sesi bir müzik tarzından veya enstrümandan diğerine dönüştürebilen, enstrümantal ve vokal eşlikler oluşturabilen ve sıfırdan yeni müzik veya enstrümantal pasajlar üretebilen bir dizi yapay zeka aracı geliştiriyorlar. Araçlar, sanatçıların fikirlerini müziğe dönüştürmelerini kolaylaştırmak için tasarlandı, örneğin mırıldanmalardan gitar riffleri yaratmak gibi.

Deepmind’ın SynthID’si yapay zeka sesini etiketliyor

Lyria ile üretilen tüm içerikler, Google Cloud’un Vertex AI’sinde Imagen tarafından üretilen AI görüntülerini tanımlamak için kullanılan aynı teknoloji araç seti olan SynthID ile etiketleniyor. Filigran makineler tarafından görülebiliyor, ancak insanlar tarafından görülemiyor.

Benzer şekilde SynthID, yapay zeka tarafından üretilen sesleri insan kulağının duyamayacağı ve dinleme deneyimini etkilemeyecek şekilde filigranlanıyor. Bunu, ses dalgasını bir sesin frekans spektrumunun zaman içinde nasıl değiştiğine dair iki boyutlu bir görselleştirmeye dönüştürerek yapıyor.

Deepmind, filigranın ses materyali, örneğin gürültü ekleyerek, MP3 sıkıştırarak ya da parçayı hızlandırarak veya yavaşlatarak değiştirilse bile tanınabilir kalması gerektiğini yazıyor.

SynthID, bir şarkının bazı bölümlerinin Lyria tarafından yaratılmış olması durumunda bile yardımcı oluyor. Google Deepmind’a göre bu “yeni yöntem”, özellikle ses alanında daha önce yapılmış hiçbir şeye benzemiyor.

Birkaç gün önce YouTube, platformda yapay zeka tarafından üretilen görsel-işitsel içerikle başa çıkmak için yeni kurallar yayınladı. Diğer şeylerin yanı sıra, video platformu artan etiketleme gereksinimlerine odaklanıyor ve AI içeriğinin hem insanlar hem de AI tarafından tanımlanmasını istiyor.

YouTube için müzik jeneratörü, kullanıcıların etiketleme de dahil olmak üzere üretilen içerik üzerinde kesin kontrole sahip oldukları araçlarını kullanmalarını sağlayarak platformlarında yapay zeka tarafından üretilen müzik üzerinde daha fazla kontrol elde etmek için stratejik bir araç olabilir.

Yapayzeka.news’in hiçbir güncellemesini kaçırmamak için bizi Facebook, Twitter, LinkedIn, Instagram‘ ve Whatsapp Kanalımız‘dan takip edin.